眼见不一定为凭?生成式AI带来的信任危机!

-

提示词给的资讯越多,就越有机会用绘图 AI 生成想要的客制化图片。(图|研之有物/资料来源|Midjourney)(photo:UpMedia)你看过美国前总统川普被警方逮捕的影片吗?又或是英国女王在皇宫中大跳热舞的片段?多年来,人们普遍相信着「有图有真相」的道理,然而,随着图像与影音相关的生成式 AI 越发成熟,我们似乎再也不能轻易相信自己的双眼。而在真假影音的差异可说是微乎其微的状况下,我们究竟该如何判断资讯真实性?中央研究院资讯科技创新研究中心的副研究员陈骏丞与团队每天在寻找的,便是有效又好用的解决方案。本次,中研院「研之有物」将透过专访,从生成式 AI 的原理开始了解,一步步为各位解开深伪影像的神秘面纱。

生成式 AI 怎么这么红?因为成熟又好用!

一讲到生成式 AI,许多人都能立刻喊出「ChatGPT」的大名,足见这个领域之热门程度。其实,生成式 AI 发展并不是近年才开始的事,可是为什么直到最近,才受到社会大众的热烈欢迎呢?

中研院资创中心的陈骏丞副研究员认为,其中最关键的原因,莫过于 AI 程式的优秀表现开始让一般人很「有感」。由于生成式 AI 的相关研究快速发展,基础建设在近年来逐渐成熟,使用介面也设计得十分亲民,让大众能透过极为直觉、简单的方式去使用,实际体会到应用的效果,例如改善工作效率、处理图像任务等,再加上大众媒体的渲染,便带起了 2023 前半年的 AI 风潮。

陈骏丞笑着说,虽然自己不是文字生成式 AI 的专家,但使用「ChatGPT」时,也发现到它真的能做到很多事,比早期的 Siri 效果更好、更准确。的确,对于我们来说,这款基于 OpenAI 开发的大型语言模型(Large Language Model)的聊天机器人(Chatbot),就彷彿是一个全能小秘书一般,可以整理文案、改错字,甚至连写程式码都不在话下。

场景转换到影像领域,如今市面上也有同样由 OpenAI 打造出的图像生成平台「DALL·E 2」,或是大名鼎鼎的「Midjourney 」,都可以很有效率的将使用者文字描述转换成图片。虽然这些平台生成的内容偶尔还是会出现「破图」的情况,例如头发少一块,或是出现奇怪色块等,但它们的生成速度极快,也能产生不少令人印象深刻的高品质内容;对于一般大众而言,自然充满吸引力。

陈骏丞解释,过去也有许多以文字产生图片的尝试,但品质并不佳,而现在之所以可以显得如此真实,便是借助了「扩散模型」(Diffusion Model)的强大威力。大约 2019 年左右,「扩散模型」逐渐超越了原本主流的「生成对抗网路」(Generative Adversarial Network,GAN),吸引大量研究人员投入,也因此衍生出「Midjourney」这类的图片服务,打个字、按个钮便能生成美美的图片。进阶使用者还可以输入如同咒语般长的自订提示词(Prompt),生成符合需求的图片,甚至还有人专门训练生成提示词的 AI,各种 AI 艺术社群也如雨后春笋般成立。

如何打造超强大生成式 AI?原来是靠这些妙招

等等等等,什么是「扩散模型」?什么是「生成对抗网路」?想了解两者的不同,让我们先从比较「资深」的那个开始说起。

所谓「生成对抗网路」,其实是由两个网路所组成的,分别是「鑑别网路」(Discriminating Network)与「生成网路」(Generative Network)。这两者间的关系就像是考官和学生(亦敌亦友!),学生(生成网路)要负责把图生出来,交给考官(鑑别网路)去判断这张图跟真实图片的分布究竟像不像,像就给过、不像就退回去砍掉重练。

至于考官(鑑别网路)为什么能如此精确呢?因为研究员会预先餵给它真实的图片,好协助鑑别网路做出足够专业的判断、给予精准回馈。而学生(生成网路)则在这一次次「交作业、修正、交作业、修正」的过程中,画出越来越接近真实模样的图片。

*(photo:UpMedia)生成对抗网路的概念比喻图,生成网路与鑑别网路这两组神经网路会相互训练,生成网路所产出的图片会越来越接近鑑别网路的目标,差异越来越小。(图|研之有物/资料来源|李宏毅)

相比起 GAN 对错分明、马上定生死的特点,「扩散模型」採取的路径相对而言非常迂回,但是结果更为精准,如果採用知名电脑科学家台大电机系李宏毅教授的比喻,扩散模型就像是从一块大石头里面刻出大卫像,图片就在杂讯当中!

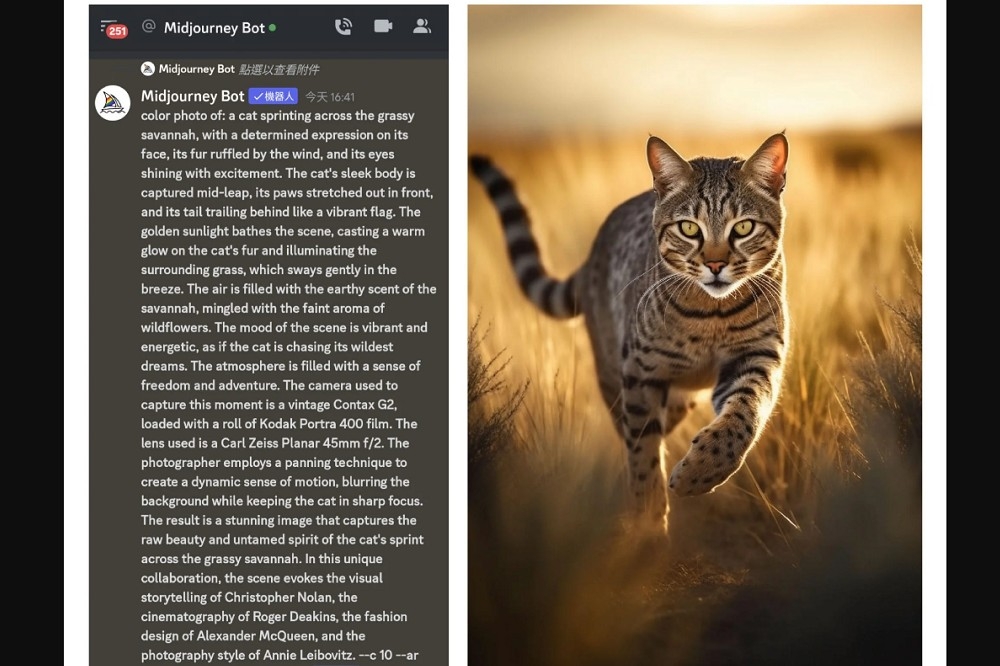

「扩散模型」在训练期间的第一步是加噪(add noise),以猫为案例来说,扩散模型的原理就是将一张正常的猫咪图片,用统计方法取样出一张特定大小的杂讯图(例如 512*512),过程中研究人员会控制参数去加上高斯杂讯。第二步是去噪(denoise),透过减去预测的高斯噪声,得到干净的原猫图。模型训练的越好,预测的高斯噪声量越准。

训练好之后,「扩散模型」在输出的时候,为了输出符合使用者文字指令的猫咪图片,模型会从随机的杂讯图开始,应用训练过程的去噪器,像物理的扩散过程一样,逐渐改变每个像素点的值,反覆去掉噪点,得到最后新的猫咪图。

如果有用过 Midjourney 的人,应该也会发现 AI 收到文字指令开始产图的时候,是从一张模煳不清的图片,一颗颗像素逐渐改变,变成你要的图。

陈骏丞指出,由于这些噪声都是研究员自己加的,所以控制度极高,也可以掌握其中细部的变化过程。而这种「保姆式」训练法,最大的好处就在于:扩散模型是一种渐进式学习的过程,因此对于细节的掌握度将会更高。

陈骏丞提到,两种方式的训练时间其实差不多,但以执行时间来说,「扩散模型」会比较久一点,因为需要慢慢摸索,而 GAN 则是几乎一步到位。不过,虽说处理时间可能较长,「扩散模型」却也因为训练比 GAN 更稳定与更全面这份特质,可以训练很大的资料集,也能生出较为丰富多元的成果。

*(photo:UpMedia)扩散模型透过加噪和去噪来训练模型,利用去噪来生成图片。实际生成图片的过程,就是逐步去除噪声的过程。

(图|研之有物/资料来源|李宏毅)方便好用也危险!生成式 AI 的黑暗面

能生出细腻而接近真实的图乍听之下是好事,但它同时也是一把双面刃,可能伴随着侵害智财权、制造假消息等等负面效应。

在训练生成式 AI 相关模型时,必定需要大量的资料做为参考,而以 AI 绘图来说,许多资料其实是未经授权的网路图片;假设宫崎骏的图片被盗用去训练开源模型,那这些生成式 AI 后来生出的图可能就会带有宫崎骏的风格或曾经画过的元素,这样是否会带来侵权或抄袭的问题?是我们必须思考的重要课题。

而说到假消息,就一定得谈到值得关注的「深伪」(Deepfake)技术。虽然这个词很容易让人联想到一些负面的事件,比如新闻报导网红小玉用深伪技术制作不雅影片。然而,陈骏丞澄清,深伪技术最常出现的场域其实是在电影工业中。其中,最知名的应用,莫过于《玩命关头》系列电影,在拍摄期间主角保罗沃克不幸意外离世,剧组便透过电脑合成影像技术,让主角的弟弟替身上阵,主角身影得以再次与观众相见。

矛与盾的无尽之战!来套深伪影像的防毒软体吧!

深伪技术若运用得宜,便是赚人热泪的神器,反之,却也可能成为万人唾骂的帮兇,面对这样强大的工具,难道我们只能乖乖束手就擒吗?才不!既然 AI 如此强大,那我们就训练 AI 来对付它!

陈骏丞分享道,反制深伪影像常用的方法便是训练「二元侦测器」,借由蒐集大量真实与伪造影像资料去训练 AI,让它得以判断影像的真伪。然而,深伪有很多种,而二元侦测器对于没有看过的资料,表现会大打折扣。

过去人们是用 GAN 来生图,现在是用扩散模型来产图,未来也有可能出现新的方式,想要找出一个一劳永逸的方法,其实并不容易。

陈骏丞认真地说,深伪侦测的过程,其实很像在研发一套「防毒软体」,防毒软体很难永远跑在病毒前面,大多是遇到病毒再往下思考解方。但是,面对这样的情况也不用完全悲观,因为训练侦测模型可以透过「非监督式」和「自监督式」等方式去进行模拟,进而得出比较能广泛应用的工具。

除了侦测深伪的错处之外,我们也可以针对训练资料动点手脚,像是加上一些「浮水印」。许多生成式 AI 的训练资料来自图库图片,其中许多图片自带防盗浮水印,假设 AI 蒐集了这些素材,往后生成的图片中可能就会出现「版权所X」等等字样。

而我们能做的,便是为训练资料加上肉眼看不见的浮水印。比如说,在影像领域中,伽码(gamma)指的是用来编(解)码照度的非线性曲线,我们可以偷偷将浮水印藏在人眼看不见的伽码范围中,唯有调整到特定区域,才能看见浮水印。听起来是不是很像我们小时候用柠檬汁玩的隐形墨水呢?

同样是浮水印,我们也可以将它藏在人眼比较不敏感的频率中,然后偷偷放去图片中边边角角的地方,让人眼看不出来。 加入浮水印后,我们就可以进一步训练侦测器去寻找浮水印。假设侦测器能在图上面找到浮水印,那就可以借此推断图的真伪。

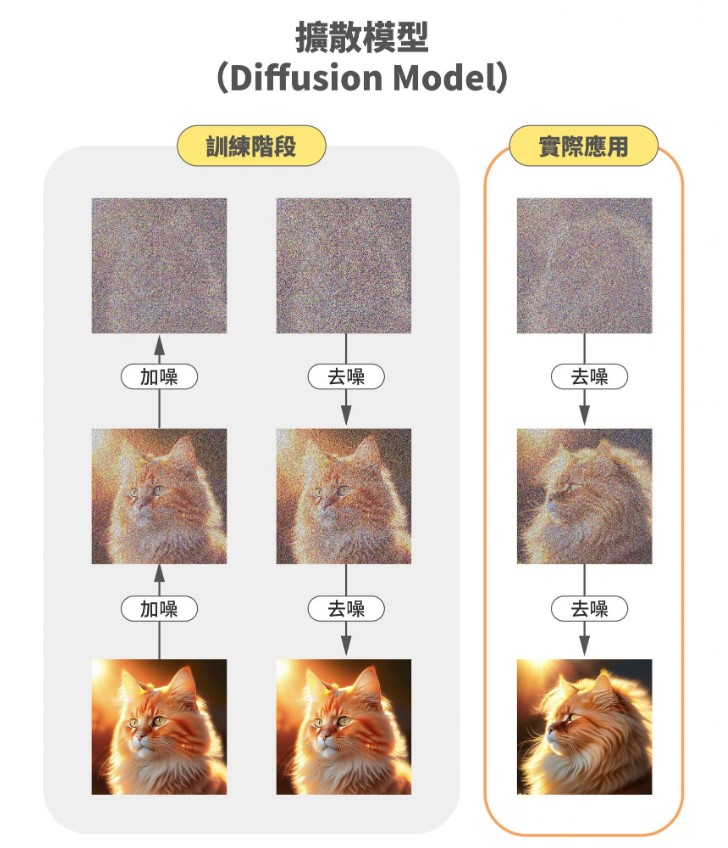

而相对侦测、加浮水印等等「补救」的方式,假设我们已经掌握了一些模型的架构,便能透过添加「对抗样本」(Adversarial Examples),直接攻入生成式 AI 的大本营,让这些深伪 AI 只能生出一些乱七八糟、毫无逻辑的图片,或是强迫生成特定的图案。例如找出几个常用、能进行脸部特征操作的 GAN,针对它们研发相关对抗样本,如此一来,只要加入了团队开发的噪声,便能同时打坏这几种 GAN 的生成。

*(photo:UpMedia)对抗样本是防御深伪模型的有效手段,干扰深伪模型的影像生成。(图|研之有物)

深伪侦测好难做?齐心协力打造深伪影像侦测器!

这么看下来,深伪侦测若想做得好,需包含的面向又多又广、还很复杂,但请各位别紧张,陈骏丞与中研院、台湾大学、台湾科技大学、成功大学、中央大学以及国家高速网路与计算中心其他教授与研究员共同组成的研究团队,最近才刚打造出一款泛用性相对较佳的「深伪影像侦测器」,团队其他研究成员包括王新民研究员、曹昱研究员、花凯龙教授、许志仲教授、许永真教授、蔡宗翰教授与国网的郭嘉真研究员。

这款侦测器以慕尼黑工业大学和义大利拿坡里费德里克二世大学共同提出的伪造人脸资料库「Face Forensic++」为基础,透过自监督的方式去产生出深伪的各式可能形式。

团队是如何训练侦测器的呢?具体的运作方式是:先侦测轮廓、产生一个「面罩」去界定人脸的位置;接着,再让侦测器透过些许微调去模拟深伪影像的特征;再来,将这些「模拟的深伪影像」丢回去当作训练资料。经过训练的侦测器便能大幅升级,可以根据颜色、频率、边缘特征等等参数,去判断影像的真伪,甚至可以帮这些深伪影像区分难度呢!

听起来,这样的侦测器已经很完美了?陈骏丞笑着说,这样的内容一经发表,伪造资讯的一方可能又会想办法绕过这些地方,对双方来说,这就是场永无止尽的攻防战,对此,陈骏丞表示,团队想要完成的,便是:

「尽量提供一个比较完整的解决方案,提供普罗大众各种可能的工具,尽可能让大家的资料不会被伪造,并帮助他们侦测。」

别相信任何人!抱持怀疑才是唯一真理

这一份深伪影像侦测器凝结了众人的心血,陈骏丞很期待未来侦测器正式上线后,能透过国家高速网路与计算中心设计的好用介面让大家方便操作,在诈骗防治方面尽一份心力。同时,也期待各界看到这个工具的潜力,愿意成为坚强的支持力量。

那在这么好用的工具正式上线之前,我们又该如何去判断影片的真假呢?陈骏丞传授了我们一些独家小绝招:首先:注意「姿势」,深伪影片可能会出现一些不自然的怪异姿势;其次,可以关注「背景」,比如突然出现裂痕之类的;再来,也要看看「衣服」等等细节,可能会发现破图的踪迹。而影片若是出现侧脸时,也比较容易发现瑕疵,比如说头发动得很怪、眼神不对、牙齿没牙缝等等。

另一方面,如果影像的解析度太低,也会影响深伪侦测的准确性,所以,对于太过模煳的图片、影片,都应该格外小心。

陈骏丞也提醒,随着相关造假技术日臻成熟,图片、影片中的细微瑕疵将会越来越难以察觉,这时候,一定要谨记以下原则:

「不能像以前一样看到影片就觉得是真的,还是要抱持怀疑的态度。」

假设看到一些违反常理或「怪怪」的内容,一定要多方查证,绝不可以马上就相信。

读到这里的各位,想必已经被陈骏丞装上了一套强而有力的「深伪防毒软体」,希望大家带着这层防护罩,在生活中远离虚假、靠近真相!(p.s. 要记得定期更新啊!)

※本文授权转载自研之有物(中央研究院)官方网站。