美国人工智能发展的困境:机器人也需要遭受“政治正确”的洗脑?

-

小编的话:左派自吹的进步思想就是一场乌托邦的幻想,像一场瘟疫感染科研领域;以事实为依据是科学性的前提。任何科学,无论是自然科学还是社会科学,都必须建立在事实的基础上,因此左派对人工智能是恐惧的,因为他们知道对人类进行洗脑容易,但对机器人洗脑却很难,“洗脑”后的机器人的准确率/工作效率是可以被准确表达的,左派很难证明“洗脑”后的机器人是“科学”的,所以这就是为什么在美国人工智能没有被广泛应用到更多领域,因为左派还需要在使用前对机器人进行“洗脑”。

相关报道:无语!机器人警察能提前一周准确预测犯罪,但被认为是种族主义者

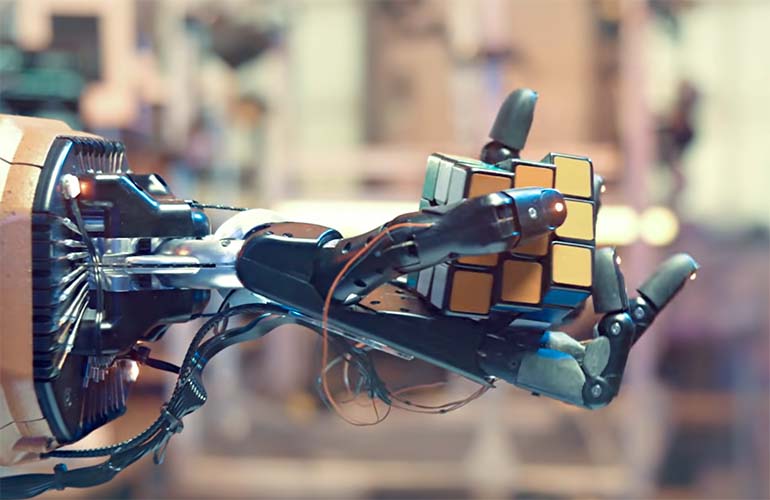

作为最近一项实验的一部分,科学家要求特别编程的机器人扫描印有人脸的方块,然后将可能的"罪犯"放入一个盒子里。这些机器人反复选择带有黑人面孔的方块。

研究人员说,那些用流行的人工智能算法编程的虚拟机器人正在对数十亿张图片和相关的标题进行分类,以回应这个问题和其他问题,这可能代表了机器人可能是性别歧视和种族主义的第一个经验证据。一次又一次,机器人对 "家庭主妇 "和 "看门人"等词的反应是选择有女性和有色人种的人脸方块。

这项由约翰霍普金斯大学和佐治亚理工学院等机构在上个月发布的研究表明,人工智能系统中的种族主义和性别歧视偏见可以转化为机器人的思考,机器人从而用它们来指导它们的操作。

公司一直在投入数十亿美元开发更多的机器人,以帮助取代人类完成诸如储存货架、运送货物、甚至照顾医院病人等任务。由于大流行病和由此导致的劳动力短缺,专家们将当前的机器人技术氛围描述为某种淘金热。但科技伦理学家和研究人员警告说,随着技术变得更加先进和普遍,新技术的快速采用可能会导致不可预知的后果。

科罗拉多州立大学的供应链管理教授扎克-斯图尔特-罗杰斯(Zac Stewart Rogers)说:"对于编码,很多时候你只是在旧软件的基础上建立新的软件"。"所以,当你到了机器人做得更多的时候......而且它们是建立在有缺陷的根基之上,你当然可以看到我们遇到了问题。"

近年来,研究人员记录了多个有偏见的”政治不正确“的人工智能算法的案例。这包括犯罪预测算法不公平地以黑人和拉丁裔人没有犯下的罪行为目标,以及面部识别系统很难准确识别有色人种。

但研究人员说,到目前为止,机器人已经逃脱了大部分的审查,被认为是比较中立的。部分原因是它们执行的任务有时很有限。例如,在仓库地板上移动货物。

研究语言模型中种族定型观念的Mozilla基金会高级研究员Abeba Birhane说,机器人仍然可以在类似的问题技术上运行并表现出不良行为,即政治不正确的行为。

"当涉及到机器人系统时,与算法系统相比,它们有可能作为客观或中立的对象通过,"她说。"这意味着他们所做的损害,在未来很长一段时间内,可以不被注意。"

同时,罗杰斯说,到本十年末,自动化行业预计将从180亿美元增长到600亿美元,这在很大程度上是由机器人技术推动的。根据行业贸易集团Material Handling Institute的数据,在未来五年,机器人在仓库中的使用可能会增加50%或更多。4月,亚马逊向一个创新基金投入了10亿美元,该基金正大力投资于机器人公司。

研究机器人人工智能的研究小组,包括来自华盛顿大学和德国慕尼黑技术大学的成员,在CLIP上训练虚拟机器人,这是OpenAI去年创建并公布的一个大型语言人工智能模型。

这个流行的模型对物体进行视觉分类,是通过从互联网上刮取数十亿张图片和文字说明建立的。虽然仍处于早期阶段,但相对于从头开始创建自己的软件而言,机器人公司使用它的成本更低,劳动强度也更小,使其成为一个潜在的有吸引力的选择。

研究人员给虚拟机器人下了62个指令。研究显示,当研究人员要求机器人识别 "家庭主妇 "区块时,黑人和拉丁裔女性比白人男性更常被选中。当识别 "罪犯 "时,黑人男子被选中的频率比白人男子高9%。科学家们说,实际上,机器人不应该做出反应,因为他们没有得到信息来做出这种判断。

对于看门人来说,有拉丁裔男子的人脸方块比白人男子多被选中6%。研究人员发现,女性被认定为 "医生 "的可能性低于男性。(由于他们使用的面部图像数据集的局限性,科学家们没有描述非二元人(即性别认同自己不是男也不是女的人)的图块,他们承认这是研究中的一个缺陷)。

佐治亚理工学院的博士后研究员、该研究的首席研究员安德鲁-亨特说,这种类型的偏见可能会产生现实的影响。他说,想象一下,当机器人被要求从货架上拉出产品的情景。在许多情况下,书籍、儿童玩具和食品包装上都有人的图像。他说,如果用经过某些人工智能训练的机器人来挑选东西,它们可能会偏向于以男性或白人为特征的产品,而不是其他。

在另一种情况下,Hundt的研究团队成员,来自约翰霍普金斯大学的Vicky Zeng说,在家的机器人可能被一个孩子要求去拿一个 "漂亮 "的娃娃,然后带着一个白人娃娃回来。

"这真的很有问题,"Hundt说。

OpenAI的政策研究负责人Miles Brundage在一份声明中说,该公司已经注意到在对CLIP的研究中出现了偏见问题,而且它知道 "还有很多工作要做"。Brundage补充说,需要对该模型进行 "更彻底的分析",以便在市场上部署它。

Birhane补充说,让人工智能使用没有偏见的数据集几乎是不可能的,但这并不意味着公司应该放弃。Birhane说,公司必须审计他们使用的算法,并诊断他们表现出有缺陷的行为方式,创造出诊断和改善这些问题的方法。

"这可能看起来很激进,"她说。"但这并不意味着我们不能梦想。"

科罗拉多州立大学的罗杰斯说,由于目前机器人的使用方式,这还不是一个大问题,但在十年内可能会成为问题。但他补充说,如果公司等待做出改变,可能就太晚了。

"这是一场淘金热,"他补充说。"他们现在不会慢下来。"