张宏江与OpenAI创始人Sam Altman尖峰对谈:GPT-5不会很快到来

-

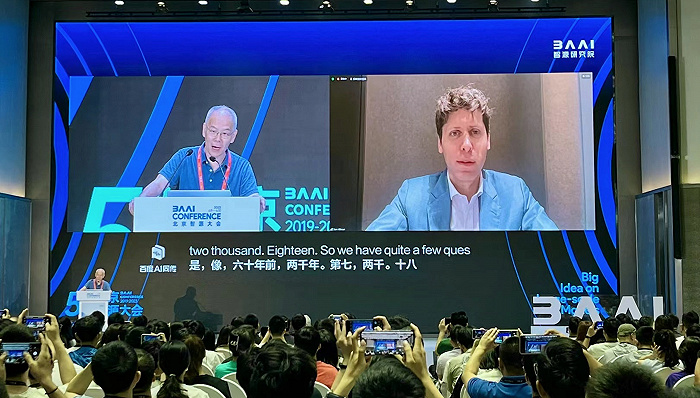

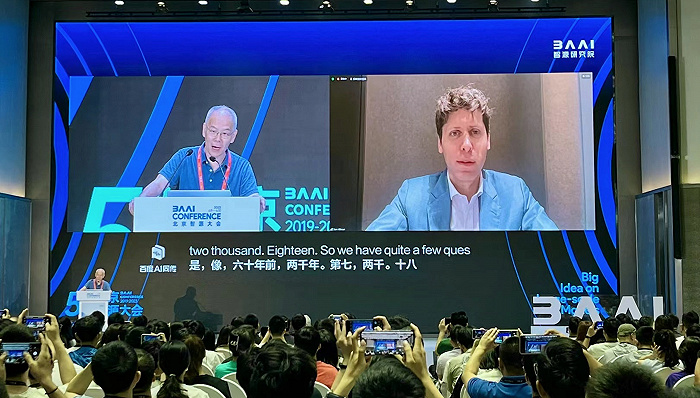

图源:智源大会图源:智源大会(photo:JieMian)界面新闻记者 | 李京亚

大模型时代出现了很多本世纪人类社会面临的最紧迫或最有意义的科学挑战,人机对齐便是其中之一。如何确保越发强大和通用的人工智能系统安全可控,符合人类意图和价值观,这一重要安全问题被称为对齐(AI alignment)。

如果用更形象的表达,LLM大语言基座模型一般是基于繁杂网络预料训练,本身未经调校,原始能力相当狂野,和"遵从用户指令以产生安全而有用的结果"的目标并不一致,因此需要使用对齐(alignment)技术来将大模型和人类的意图安全对齐,也就是OpenAI所做的一系列复杂人机标注过程。

但是在大模型演进过程中,GPT系列大模型适应人类语言的表达方式的同时,性能也被牺牲,特别是近期,业界关于对齐的代价已有争端显现。由微软研究院发布的论文提出惊人论断:对AI模型所进行的任何AI对齐,都会损失模型的准确性和性能,其依据是当实验员将相同需求提供给集成GPT-4模型并进行了安全性AI对齐的ChatGPT后,图像的输出质量下降了一大截。

“随着我们更接近AGI,任何不符合目标的潜在影响和成都都将呈指数增长。”Sam Altam在6月10日北京智源大会会场再次强调了对齐的价值,他称GPT-4耗费8个月时间来进行艰苦的对齐工作,是极其必要的,而且走在了正确的道路上,“GPT-4的对齐程度超过当前所有的代码”,而此后对于更高级的系统,对齐尚未解决,要用新的技术方法。

这是ChatGPT之父首次在中国的会议场合公开发表意见。

6月9日,为期两天的“北京智源大会”在北京中关村开幕,这是连续举办了五届的“AI顶级盛会”,本次把大量AI大佬囊括其间,参会者包括图灵奖得主Geoffrey Hinton、Yann LeCun、Joseph Sifakis和姚期智、张钹、郑南宁、谢晓亮、张宏江、张亚勤等200余位人工智能届顶尖人才,会场内人头攒动,学者、研究员、创业者、大厂工程师和投资人不乏其例,所有分论坛几乎都被挤满。今年以来,国内尚未有一场盛会如这般吸引多维度高密度的AI人才。

*(photo:JieMian)Sam Altman在6月10日的重头戏——“AI安全与对齐”论坛上以视频连线形式现身,进行了开场演讲,并接受了智源研究院理事长张宏江的问答,他围绕模型的可泛化性系统输出了观点,成功吸引到了全球的目光。

演讲中,Sam Altam沿着通用人工智能AGI系统的拓展思路和安全治理要素展开,与他近期观点类似,他呼吁需要国际合作来建立对日益强大的人工智能系统安全开发的全球信任,还应该增加透明度和知识共享的机制,来推进AGI安全方面的进展。

他特别提到,最近OpenAI发表了一篇论文,使用GPT-4来解释GPT-2中的神经元,他相信先进的机器学习技术可以进一步提升AI解释力。

他还表示,OpenAI的新晋投资也集中在解决对齐的技术问题之上,“第一是如何使用人工智能系统来监督人工智能系统,第二是如何更好解释模型内部的要素”。他总结称,OpenAI的最终目标是找到更好的技术,实现AGI的非凡利益,同时降低风险。实际上,OpenAI对AI领域的投资地图集中于应用层企业,其高管近期也提到有意决定在模型基础设施层减少价值提取,保持低价格以促进更多开发,以便将来大部分价值在不同应用领域的应用层产生。

相比Sam稍显常态化的个人发言,他与智源研究院理事长张宏江的一对一问答环节更为吸睛。

*(photo:JieMian)张宏江抛出了业界关心的“造轮子”问题:世界上如果只把大模型数量维持在三个之内,是否会更有利于AI安全。Sam Altam给出了一个开放性回答,即比模型数量多寡更为重要的是,是否能有一个系统,让任何一个强大的模型都经过充分的安全测试,是否能有一个框架让任何一个大模型的创造者,既有资源、也有责任,确保创造出的东西是安全和对齐的。

此外是关于对齐。Sam Altam提到对齐这个词有不同的用法,传统意义上是指让模型按用户意图行事,但应该不止于此,“现在我们还需要(大模型)回答其他一些问题,比如如何验证系统是否做了我们想要它们做的事情,以及我们要根据谁的价值观来对齐系统,但我认为重要的是要看到实现安全人工智能所需要的全貌。”

对于外界普遍关心的GPT-5,Sam Altam表示不会很快到来,但目前OpenAI在探索很多可能的新范式,还计划将OpenAI成立初期的机器人工作重新拉回账面。

近期,Sam Altam行程紧凑,上月,他遍历欧洲各国与多位议员和领导人会面,讨论人工智能的前景和威胁,本周,他走访以色列、约旦、卡塔尔、阿联酋、印度和韩国。随着行程的深入,他的话题开始显得重复,基本围绕模型信仰、AI安全、公司表层战略平淡展开,在以色列特拉维夫大学站中,他带着OpenAI首席科学家Ilya Stutskever出场,相比于他,后者的观点更犀利有趣。

不过,Sam在智源大会上提到,对全球之旅收到的各类回馈非常满意,在过去六个月中,关于人工智能的风险和机遇向的讨论已经有了很大进步,人们开始真正致力于找出一个框架。他也提到,全球合作还是相当困难的,不是一个纯粹的技术问题,涉及不同背景下不同国家的用户偏好,“需要很多不同的投入才能实现这一目标”。

最后值得一提的是,Sam Altam提到,中国拥有一些世界上最优秀的人工智能人才,“从根本上讲,我认为这使研究人员在解决许多不同的AI系统的问题上面临困难。中国是世界上最好的地方,我真诚希望中国和美国的研究人员能对此做出巨大贡献。”

我最近在做全球巡回的访问,期间穿越五大洲近20个国家,接触了诸多的学生、开发者,这趟出行令人振奋,我们见证了全球各地的人们利用OpenAI的新技术来改变生活方式,我们也获得了非常宝贵的意见,以便于让我们的工具优化得更好。此外,我也有机会拜访了多位外国领导人,讨论确保越来越强大的人工智能系统安全部署所需的各种基础工作。

坦白说,世界的注意力主要集中在解决当今的人工智能问题上,很多问题的解决非常迫切,我们还有很多工作要做,不过鉴于我们已经取得的进展,我相信我们会实现目标。

今天,我想谈谈未来。具体来说,我们正在看到人工智能能力的迅速增长,现在需要做的是负责任地将其应用到世界中去。科学的历史告诉我们,技术进步遵循指数曲线。这在农业、工业和计算革命中得到了验证。现在,我们亲眼目睹人工智能变革,不仅因为我们正在见证它,而且因为它带来的变革速度。

它正在迅速拓展人类的想象力。想象一下,在未来十年,人工通用智能系统(常称为AGI)将会超过90年代初,人类所具备的专业水平,这些系统最终可能超过人类最大体量公司的总体生产力,这里的潜在收益是巨大的。

人工智能革命将带来可共享的财富,使改善人类互动标准成为可能,但我们必须管理好风险,并共同努力来实现预期目标。我时常感觉一些人放弃他们应有的权益来实现人类共同的目标,在今天很多领域仍然如此——大国之间经常通过合作的方式来实现共同目标,这种形式的合作对关键的医学和科学进展都会带来好处,比如根除小儿麻痹症和天花等疾病,以及全球减少气候变化风险的努力。

随着越来越强大的人工智能系统的出现,全球合作的利益变得前所未有地重要。如果我们不做好规划,一个设计用于改善公共卫生结果的未对齐的AI系统,可能会通过提供不平衡的建议来破坏整个集体系统。同样,一个旨在优化农业实践的人工智能系统可能会无意中损害经济和资源的消耗,缺乏对长期可持续性的考虑,从而影响食物生产和环境平衡。我希望我们都能认同,推进AGI安全是我们寻找共同立场的最重要领域之一,我希望把时间都集中在我们已经开始的领域。

其中一个领域是AGI治理。AGI的力量可以从根本上改变我们的文明,这突显了有意义的国际合作、协调的必要性,每个人都会从积极的治理方法中受益。如果我们将这个核心的最先进政策网络化,AGI系统可以为全球经济创造无与伦比的经济丰富,解决共同的挑战,如气候变化、全球健康安全,并在无数其他方面提升社会福祉。我深信这也是未来,我们深处同一个星球,需要明确投资AGI的安全性的意义。

我们必须为鲁莽的开发和部署可能引发的问题负起责任,其中最重要的两个领域是:首先,我们需要建立起包容的国际准则和标准,并在所有国家对AGI的使用中建立平等、统一的防护措施。其次,我们需要国际合作,以可验证的方式在全球范围内建立对越来越强大的AGI系统安全开发的信任,我知道这并不容易。

作为国际社会,我们需要对安全进行长期的关注和投入,以确保我们做得正确。《道德经》提醒我们,“千里之行,始于足下”,最有建设性的第一步是与国际科技界展开合作,推动增加AGI安全技术进展的透明度和知识的机制,发现紧急问题的研究人员应该与更多人共享研究成果。

我们需要更加深入地思考如何在鼓励推动国际合作的同时尊重和保护知识产权。如果我们做得好,这将为我们打开深化合作的新大门。更广泛地说,我们应该推动并引导与安全研究一致的投资。

当前,我们关注的是如何使AI系统成为一个有益和安全的助手,这对应的是如何训练模型,使其在没有安全威胁的前提下发挥积极作用,不过,随着AGI时代的接近,其带来的潜在影响、问题将呈指数级增长,所以,我们需要通过主动应对AGI带来的潜在挑战,将未来灾难性后果的风险降至最低。

从GPT-4完成预训练到部署,我们花了八个月的时间来研究这个如何前置预判风险并给出对策的问题,我们认为我们走在了正确的道路上,GPT-4的对齐程度超过当前所有的代码。不过,对于更高级的系统,对齐仍然是一个尚未解决的问题,我们认为需要新的技术方法以及加强治理监督,毕竟未来的AGI,可能是一个十万行二进制代码的系统。

人类监督者很难判断如此规模的模型是否在做一些损害的事情。因此,我们正在投资于几个新的,并且希望能取得成果的方向,其中之一是可扩展的监督,尝试使用AI系统来协助人类监督其他AI系统。例如,我们可以训练一个模型来帮助人类监督员找出其他模型代码中的缺陷。

第二个方向是可解释性。我们希望更好地理解模型内部发生的事情,我们最近发表了一篇论文,使用GPT-4来解释计算机的复杂状态。虽然还有很长的路要走,但我们相信先进的机器学习技术可以进一步提高我们解释的能力。

最终,我们的目标是训练AI系统具备更好地优化自身的能力,这种方法的一个有前景的方面在于——它可以与AI的发展速度相适应。随着未来的模型变得越来越智能和强大,作为助手,我们将找到更好的学习技术,在充分发挥AI的非凡好处的同时降低风险。

我们认为,美国、中国乃至世界各地的研究人员,在应对AI领域的技术挑战上的合作,存在巨大潜力,想象人类可以利用AI来解决世界上最重要的问题,大幅改善生存条件和质量。